Intelligenza Artificiale vs intelligenza umana? Quali saranno le implicazioni future dell’AI con la vita dell’uomo?

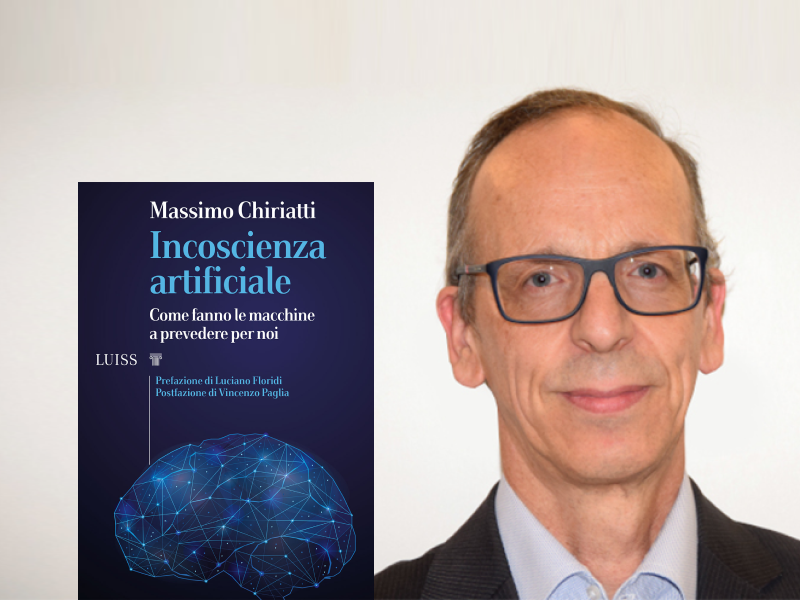

Scoprilo nell’intervista a Massimo Chiriatti, Chief Technical & Innovation Officer di Lenovo e autore di «Incoscienza artificiale. Come fanno le macchine a prevedere per noi»!

Inoltre, Massimo sarà ospite il 14 marzo alle ore 17 del webinar insieme a Marianna Bergamaschi Ganapini, PhD and Assistant Professor of Philosophy allo Union College di New York, quindi quale migliore occasione per approfondire il tema e preparare delle domande da fargli durante la diretta? 😉

Comunque, puoi iscriverti al free webinar «Incoscienza Artificiale: i rischi e le opportunità in un futuro sostenibile ed etico» qui.

Ciao Massimo, ci racconti cosa ti ha spinto a scrivere «Incoscienza artificiale. Come fanno le macchine a prevedere per noi»?

Stiamo assistendo a un’accelerazione nella quantità di informazioni disponibili, che supera ormai la capacità umana di comprenderle. Abbiamo bisogno di un filtro per sceglierle ed elaborarle.

Il problema è che il filtro stesso è la macchina che ha preso delle decisioni per noi con tutti i pregiudizi che sappiamo esserci nei dati e nei modelli.

Nel libro “Incoscienza Artificiale” poniamo al centro tra l’essere umano e la macchina la decisione. Chi la prende? Con quali responsabilità? Per rispondere a questa domanda ci ispiriamo a “Pensieri lenti e veloci” del premio Nobel Daniel Kahneman.

Il libro si inserisce in un filone di saggistica speculativa: vogliamo tutti sapere cosa verrà dopo. Un oracolo ci guida osservando gli algoritmi decisionali in questo iperpresente così disorientante, e incornicia un futuro che al contempo tranquillizza e alimenta le ansie contemporanee.

Si delineano i possibili domani, evidenziando le tendenze emergenti in modo che anche i non specialisti possano fare riferimento a questi scenari nella propria vita e nel proprio lavoro.

Un saggio dovrebbe separare il segnale dal rumore, e tenerlo basso: speriamo anche di esserci avvicinati all’obiettivo di riduzione della complessità.

Quali ritieni sia la definizione più calzante di Intelligenza Artificiale, in contrapposizione a quella di intelligenza umana?

L’AI, Artificial Intelligence, può essere definita un po’ poeticamente come una disciplina che ci aiuta a studiare le orme del passato per suggerirci i passi del futuro.

Le macchine non hanno una ‘intelligenza’ nel senso umano del termine, non sono in grado di comprendere il contesto. Pensiamo all’immagine di un essere umano e una macchina davanti allo specchio. Il primo si riconosce, ha un’emozione; la macchina, invece, pur avendo “imparato” milioni di immagini, non è capace di riconoscersi, perché non ha coscienza. La coscienza è la capacità di sentire i sentimenti, come il dolore, il piacere, l’amore e l’odio.

L’intelligenza è la capacità di risolvere i problemi. Ma i computer non hanno coscienza. La macchina non sa quel che fa e non ha la consapevolezza di non sapere quello che fa. Non c’è intelligenza senza il coinvolgimento umano, per questo parliamo di incoscienza. Quanto è utile o pericolosa una macchina del genere?

Le decisioni delle macchine si basano sui dati, ma questi sono sempre oggettivi e fattuali?

Osserviamo gli elementi costitutivi dell’intelligenza artificiale: i dati, gli algoritmi e la capacità computazionale.

Un conto sono gli algoritmi deterministici, il cui percorso è tracciabile, un conto sono i modelli decisionali che emergono dall’AI, basati su modalità intrinseche non pienamente comprensibili. Il software sta diventando più potente ma anche meno trasparente e più complesso. In altre parole, tali algoritmi non deterministici non ci spiegano in che modo sono arrivati alla decisione, non sono naturalmente trasparenti. L’importante è che l’ultima parola resti a noi: se gli umani possono contrarre un mutuo, se si ammaleranno o se sono adatti a un certo tipo di lavoro lo “decideremo” noi.

Se perdiamo la nostra decisione, perdiamo il futuro.

E quindi, cosa dovremmo fare?

Usare l’AI come suggeritrice e non per prendere decisioni al posto nostro.

Il tema dell’AI rimette al centro l’essere umano, che deve poter correggere le macchine: in alternativa, saranno loro che prenderanno decisioni al posto nostro.

Quali implicazioni future avrà l’AI con la vita dell’uomo e quali mondi possibili ci aspettano?

Dobbiamo fare particolare attenzione.

Una certa quantità di hype può essere innocua e potrebbe persino aiutare ad alimentare progressi reali nel campo dell’AI. Tuttavia, i sistemi di intelligenza artificiale sono ora integrati nei servizi pubblici essenziali e in altri processi ad alto rischio, quindi dobbiamo essere particolarmente vigili nella lotta contro le idee sbagliate sull’intelligenza artificiale. E soprattutto dobbiamo favorire la multidisciplinarietà delle competenze. Non dobbiamo lasciare soli i tecnici nel loro lavoro, dato il grande impatto che può avere una decisione algoritmica.

Gli impatti dei sistemi di intelligenza artificiale nella società dipendono in gran parte non dal codice che li sottende, ma da chi li utilizza e dagli scopi per cui saranno utilizzati. E queste sono tutte cose che possono essere regolate. Infatti, affermiamo che la tecnologia non è né buona né cattiva e neanche neutra, incorpora piuttosto i valori di chi l’ha prodotta e di chi la impiega.